爬虫速度过快导致服务器崩溃的原因是什么?

在互联网数据采集的世界里,爬虫扮演着至关重要的角色。它们能够自动化地搜集网络信息,但有时爬虫的操作不当,尤其是爬虫速度过快,可能会对目标服务器造成巨大的压力,甚至导致服务器崩溃。本文将深入探讨这一现象背后的原因,以及提供如何合理控制爬虫速度以避免对服务器造成损害的策略。

爬虫速度过快对服务器的影响

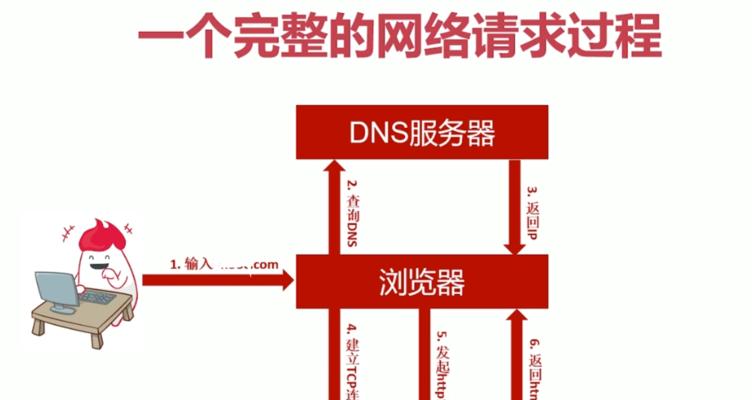

爬虫是按照一定的规则,自动浏览或搜索互联网上信息的程序。当爬虫以过快的速度请求网页时,会造成服务器接收和处理请求的负担大大增加。过多的并发请求会导致服务器资源被迅速耗尽,轻则响应延迟,重则服务器超载甚至崩溃。这不仅影响到被爬取网站的正常运行,也可能对其他用户访问该网站造成阻碍。

原因分析

1.并发请求过多

并发请求是影响服务器稳定性的重要因素。爬虫在短时间内发起大量并发请求,这相当于短时间内对服务器进行了高强度的访问压力测试。服务器的处理能力有限,一旦超出其处理极限,就会出现响应速度下降或服务中断的情况。

2.系统资源占用

爬虫在爬取数据时会消耗CPU、内存、网络带宽等系统资源。快速的爬虫会大量占用这些资源,导致服务器无法为其他用户提供服务,最终可能导致系统资源耗尽,从而造成崩溃。

3.不合理的时间间隔

爬虫的请求间隔过短,没有给服务器留下足够的处理时间。服务器在处理完一个请求后,立即被下一个请求占用,没有得到喘息的机会。长期如此,服务器始终处于高负荷状态,难以维持稳定运行。

4.缺乏异常处理机制

高效的爬虫程序应当具备异常处理机制,例如在请求失败时进行重试,或是对目标网站的robots.txt文件进行遵守,避免访问不允许爬取的页面。缺乏这些机制,爬虫可能会对服务器造成不必要的负担。

如何合理控制爬虫速度

1.设置合理的请求间隔

爬虫应该在请求之间设置合理的等待时间。通过调整爬虫的休眠时间或是并发请求数,可以有效控制请求频率,从而减轻对服务器的压力。

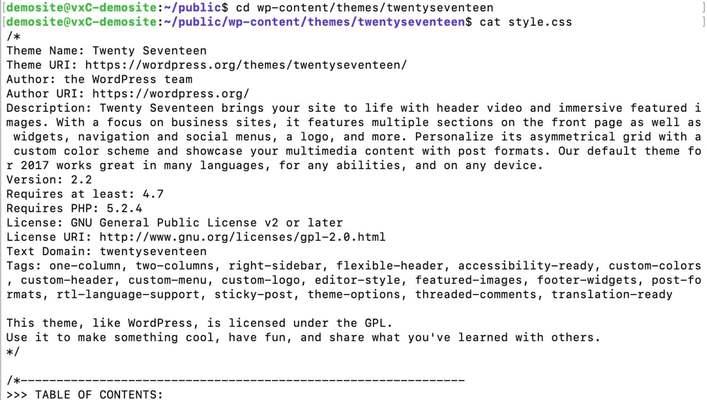

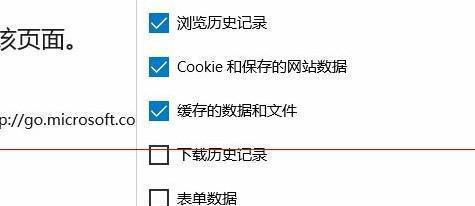

2.遵守robots.txt协议

遵循网站的robots.txt文件设定,避免爬取不允许爬取的页面。这不仅是一种良好的网络礼仪,也有助于减少对服务器的不必要请求。

3.异常处理和重试机制

爬虫应当具备异常处理机制,如请求失败则进行重试,但重试间隔不宜过短。在遇到网站暂时不可达等异常情况时,可以适当延时后重试。

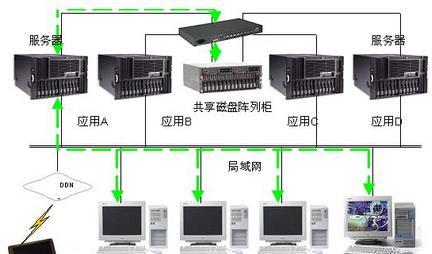

4.分布式爬虫合理分配任务

对于大规模的数据采集,采用分布式爬虫可以提高效率。但同时,需要合理分配任务和请求,避免同一服务器集中被过量请求。

实用技巧和背景信息

技巧一:识别目标网站的承载能力

在发起爬虫前,可通过观察目标网站的息,如页面加载速度、响应时间等,大致判断其承载能力,据此调整爬虫速度。

技巧二:设置爬虫访问频率上限

为爬虫设置一个访问频率上限,确保在任何情况下都不会超过该限制,以此作为爬虫行为的“保险”。

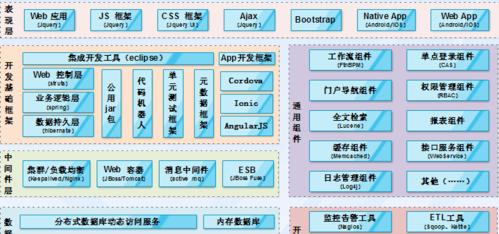

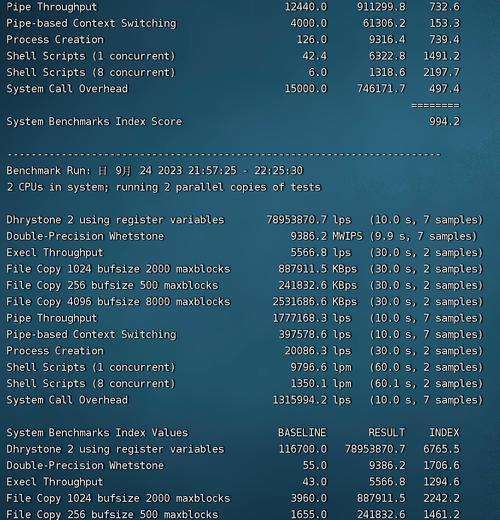

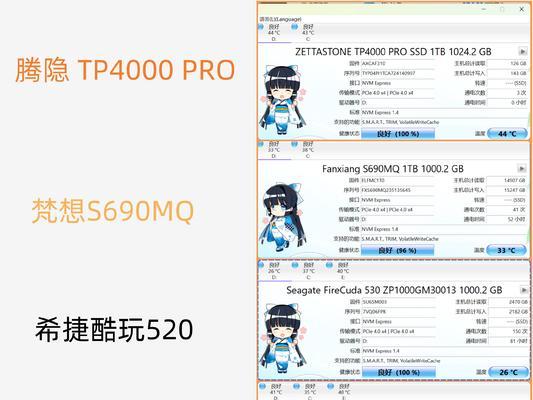

背景信息:服务器类型与稳定性

不同类型的服务器对于请求的处理能力不同。了解目标服务器的架构和性能特点,有助于我们更好地控制爬虫的速度。

背景信息:网络带宽的影响

网络带宽是影响服务器响应速度的重要因素。高速的网络带宽可以在一定程度上吸收爬虫带来的高并发请求,但这并不是无限制的。

结语

爬虫速度过快确实会对服务器造成严重影响,甚至导致其崩溃。通过合理控制爬虫速度,遵守网络礼仪,以及采用高效的编程实践,可以有效减少对服务器的负面影响,实现数据采集的可持续性。理解爬虫与服务器之间的互动关系,有助于我们更好地构建和优化爬虫程序,从而在尊重网站规则的同时,高效地完成数据采集任务。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

- 站长推荐

-

-

Win10一键永久激活工具推荐(简单实用的工具助您永久激活Win10系统)

-

华为手机助手下架原因揭秘(华为手机助手被下架的原因及其影响分析)

-

随身WiFi亮红灯无法上网解决方法(教你轻松解决随身WiFi亮红灯无法连接网络问题)

-

2024年核显最强CPU排名揭晓(逐鹿高峰)

-

光芒燃气灶怎么维修?教你轻松解决常见问题

-

如何利用一键恢复功能轻松找回浏览器历史记录(省时又便捷)

-

红米手机解除禁止安装权限的方法(轻松掌握红米手机解禁安装权限的技巧)

-

小米MIUI系统的手电筒功能怎样开启?探索小米手机的手电筒功能

-

华为系列手机档次排列之辨析(挖掘华为系列手机的高、中、低档次特点)

-

探讨路由器黄灯的含义及解决方法(深入了解路由器黄灯状况)

-

- 热门tag

- 标签列表

- 友情链接